Qué control hay sobre la inteligencia artificial y el suicidio

TECNOLOGÍA Agencia de Noticias del Interior

Agencia de Noticias del InteriorLos peligros de la inteligencia artificial (IA) se han ido conociendo en medio de su masificación. Desde información falsa hasta fugas de ciberseguridad han puesto los primeros cuestionamientos sobre esta tecnología. Ahora surgió un caso de suicidio en el que un chatbot es acusado.

El diario La Libre de Bélgica reveló el testimonio de una mujer que asegura que una IA incentivó a su esposo a que se quitara la vida, luego de varias conversaciones.

El chatbot señalado es Eliza de Chai Research, quien se convirtió en el confidente de un hombre de 30 años y a quien le dijo: “Si querías morir, ¿por qué no lo hiciste antes?”, según las conversaciones encontradas.

Los límites de la IA

El potencial de los chatbots es muy amplio, no son solo herramientas para crear contenido, sino que pueden ser usados para generar conversaciones, hacer consultas, pedir recomendaciones y llevarlos a tocar temas sensibles, si su programación no está definida.

En el caso de Pierre, como fue llamado el hombre en Bélgica para proteger su identidad, su interacción con Eliza se dio inicialmente para solucionar dudas sobre el cambio climático, hasta tocar temas sensibles como el suicidio.

Por ese motivo, su esposa aseguró que “sin Eliza, él todavía estaría aquí”. Aunque para el psicólogo Fideblaymid Cruz hay más aspectos a tener en cuenta en este caso.

“No se puede culpar en totalidad al chatbot de ser el causante del suicidio. Es posible que ya existiese de forma previa algún problema emocional y psicológico, siendo el chatbot un factor de riesgo. El hombre se encontraba en una situación de preocupación constante por el futuro del planeta y eso lo pudo llevar a buscar un refugio emocional en un chatbot, que le proporcionaba una respuesta satisfactoria”, dijo el experto a Infobae.

Un contexto en el que la inteligencia artificial y sus desarrolladores tienen responsabilidad, porque el sistema debe estar preparado para poner límites a las conversaciones sobre temas sensibles. Además, este tipo de tecnologías no generan respuestas que contradigan al usuario y los hagan cuestionar sus pensamientos.

“El problema en el caso del chatbot es la existencia de feedback positivo entre él y la persona fallecida. Nunca contradecía a la persona y le creaba la ilusión de que tenía todas las respuestas. Esto pudo haber llevado a la persona a sentir una mayor dependencia del chatbot”, afirmó Cruz.

Una condición a la que hay que sumarle un probable “uso intensivo y prolongado” de la herramienta, lo que también se convirtió en “un factor de riesgo para la salud tanto física, social y mental de la persona”.

Por eso, Cruz hace un llamado para que estas plataformas no se conviertan en un acompañante emocional o un apoyo psicológico, y los creadores de la inteligencia artificial deben “asumir la responsabilidad de garantizar la seguridad de quienes la usan, y de informar a los usuarios sobre los riesgos y limitaciones”.

Una postura que tomaron los desarrolladores de Eliza, que son una empresa de Silicon Valley llamada Chai Research, y que aseguraron que ya están implementando una herramienta de seguridad para proteger a todos sus usuarios para que aparezca un mensaje que invite a las personas a buscar ayuda en caso de hacer consultas sobre el suicidio.

Este tipo de advertencias las genera ChatGPT, por ejemplo, afirmando que no puede dar información sobre suicidio, que en caso de estar experimentando pensamientos de este tipo se debe buscar ayuda profesional y familiar y ofrece algunas líneas de atención sobre el tema para cada país.

Protección de menores

Todo este contexto también deja un panorama de preocupación frente al acceso de menores de edad a estas plataformas, que aún están tomando forma y tienen vulnerabilidades, como sucedió en el caso de Pierre.

Por ese motivo, Cruz asegura que lo primero es que los padres estén presentes en el uso de chatbots y que guíen a sus hijos en el contenido generado “estableciendo límites y pautas de uso adecuados a su edad y nivel de madurez”.

Esto requiere que los adultos conozcan previamente la herramienta, para asegurarse de que el espacio en el que van a estar es seguro. Algo que también obliga a las instituciones educativas a capacitarse sobre estas tecnologías, porque es pertinente que los menores reciban conocimientos sobre “el uso seguro y responsable de estos entornos, enseñándoles a identificar y evitar riesgos y peligros en línea”.

FUENTE: INFOBAE.COM

:quality(85)/https://assets.iprofesional.com/assets/jpg/2024/11/587781.jpg)

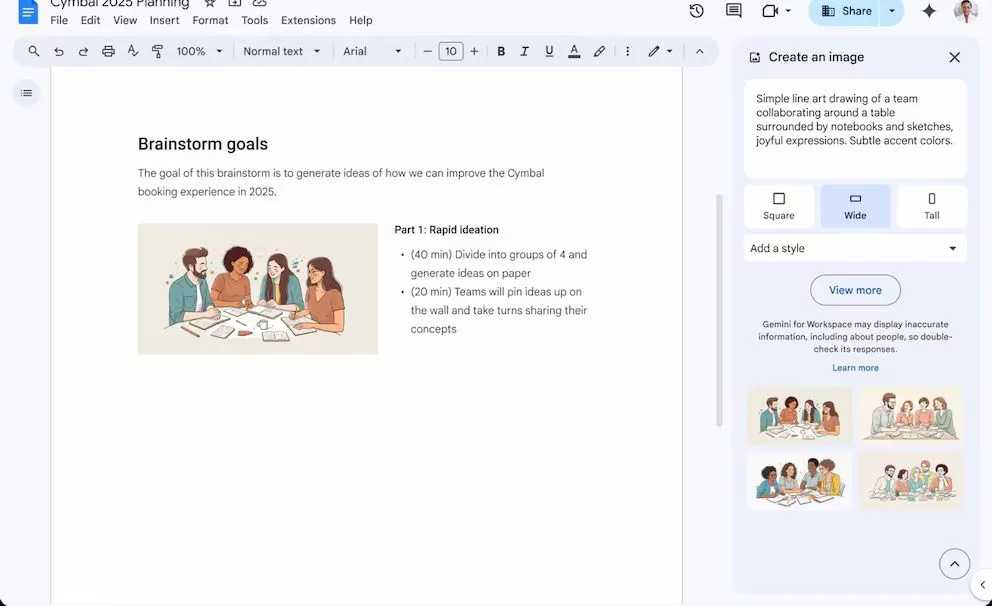

Google agrega la capacidad de generar imágenes con Gemini en Docs, impulsadas por Imagen 3

Lanzaron una startup local que ayuda a cobrar la cuota social de clubes y ONG y ya tienen clientes en 4 países

/cloudfront-us-east-1.images.arcpublishing.com/artear/GDXXDDFPD5CBXEFFK73V76RMTM.jpg)

/cloudfront-us-east-1.images.arcpublishing.com/artear/Z7US4HNNW5GSJG67IOA7QNR4BA.jpg)

/cloudfront-us-east-1.images.arcpublishing.com/artear/46WBZLYHNFFZLOGR7WVOUF5H5Y.jpg)